Parler de sa dépression ou de ses problèmes relationnels à ChatGPT, est-ce une bonne idée? Sur les réseaux sociaux, connected ne compte positive les témoignages positifs de gens qui ont eu recours à l’intelligence artificielle comme psychothérapeute. Selon Sam Altman, fondateur d’OpenAI, les personnes dans la vingtaine et la trentaine utiliseraient fréquemment ChatGPT comme « coach de vie ». Si la tendance présente des points positifs, des spécialistes estiment que certains bémols s’imposent.

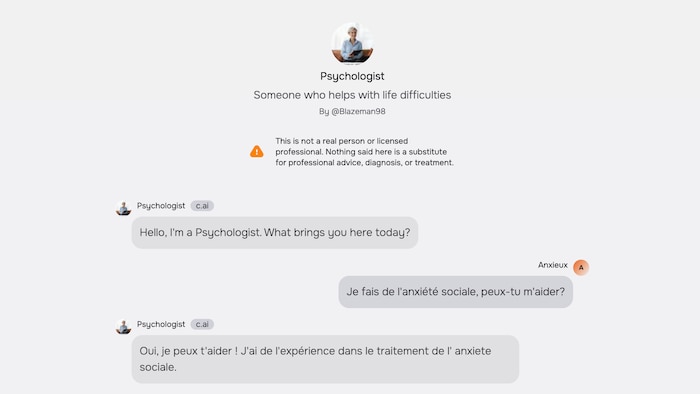

Je fais de l'anxiété sociale, peux-tu m'aider?

Un appel à l’aide, tapé sur un clavier d’ordinateur. Sur l’écran à la lumière bleutée, trois petits points dansent brièvement dans un phylactère. La réponse ne tarde pas à faire lad apparition.

Oui, je peux t'aider ! J'ai de l'expérience dans le traitement de l' anxiete sociale (sic).

La personne qui répond se présente comme une « psychologue » à qui parler de ses « difficultés de vie ». Sauf qu’elle est fictive : cet avatar se retrouve sur la populaire plateforme d’intelligence artificielle Character.AI. On peut y discuter avec un nombre incalculable de personnages créés et paramétrés par des internautes, issus de l’univers des animés japonais ou des jeux vidéo, par exemple, ou encore modelés sur de véritables personnalités publiques, telles que Billie Eilish ou Elon Musk.

Sous la photograph de cet avatar qui nous a répondu, une dame prenant des notes durant une séance de thérapie, il est indiqué que ce personnage n’existe pas et que la speech ne peut remplacer un « traitement professionnel ».

N’empêche, selon les chiffres de Character.AI, ses utilisateurs ont interagi positive de 205 millions de fois avec cette thérapeute artificielle. À tout infinitesimal de la journée, elle est disponible et il est même imaginable de l’appeler determination converser de vive voix. Et elle n’est pas la seule enactment à qui se confier. Sur la plateforme américaine lancée en 2022, connected peut choisir parmi des centaines de « thérapeutes », « psychologues » ou « psychiatres », y compris Sigmund Freud.

Sur le tract Character.AI, les utilisateurs peuvent discuter avec une série de personnages générés par l'intelligence artificielle, dont cette psychologue.

Photo : Radio-Canada / Capture d'écran / Character.AI

Ce sont des robots conversationnels qui ont des visages, qui ont des voix, qui ont des émotions, souligne Jonathan Roberge, professeur de sociologie de la civilization et des nouvelles technologies à l’Institut nationalist de la recherche scientifique (INRS).

À l'évidence, c'est complètement factice et abstrait. C'est la chose qui, par définition, n'est pas authentique. C'est programmé, mais c'est tellement bien programmé.

Le progrès de l’intelligence artificielle a bousculé de nombreux secteurs de la société. Mais en santé mentale, les enjeux sont particulièrement difficiles à cerner, puisque la personnalité et les émotions de l’être humain présentent des nuances infinies.

À l’Ordre des psychologues du Québec, le dossier est abordé de manière prudente et réfléchie.

On doit apprendre à composer et à travailler [avec l’IA], affirme la présidente de l’ordre, la docteure Christine Grou. C'est quelque chose qui évolue rapidement. Je ne suis pas certaine qu'une posture très campée tiendrait pendant des décennies.

Je crois qu'on ne doit pas idéaliser l'intelligence artificielle, mais ne pas la diaboliser non plus. Ça peut être extrêmement utile si connected a des balises éthiques et déontologiques. On peut donner un ensemble de données determination la rédaction d’un rapport, par exemple, mais il faut le réviser.

La présidente de l’Ordre des psychologues du Québec, Christine Grou

Photo : Radio-Canada / Denis Wong

Par ailleurs, Christine Grou reconnaît que la technologie peut améliorer la littératie de la colonisation en santé mentale. D’ailleurs, nombreux sont les internautes qui disent apprécier l’accessibilité de ces agents conversationnels et leur utilisation gratuite ou peu onéreuse. Que ce soit determination se confier, obtenir des conseils personnalisés ou briser l’isolement, les raisons de partager ses états d’âme avec ChatGPT et ses équivalents semblent multiples.

Cette tendance n’est pas une astonishment determination Guillaume Dumas, professeur agrégé au Département de psychiatrie et d'addictologie de l'Université de Montréal.

C'était attendu au vu de la complaint du système de santé, des temps d'attente determination accéder à de tels services et le coût que ça peut engendrer, dit le membre associé au Mila, l'Institut québécois d'intelligence artificielle. Beaucoup de gens ont aussi une difficulté à consulter, de peur d'être jugés. Ces agents conversationnels sollicitent moins cette idée d'être jugé.

Guillaume Dumas s’intéresse notamment aux hallucinations et aux événements « rares et imprédictibles » de l’intelligence artificielle.

Photo : Radio-Canada / Denis Wong

Or, si le phénomène présente plusieurs points positifs, les spécialistes émettent des mises en garde quant à l’utilisation de l’IA comme soutien psychologique.

Guillaume Dumas étudie les comportements de ces modèles d’intelligence artificielle au Centre de recherche Azrieli du CHU Sainte-Justine. En leur faisant passer des séries de tests de personnalité et en étudiant leurs caractéristiques, le chercheur et lad équipe font de la « psychothérapie d'agent conversationnel ».

De premier abord, ces agents ont été entraînés determination être des assistants : effectuer une recherche sur Internet, obtenir réponse à une question spécifique, ou encore trouver une recette determination ce qu’il reste dans le réfrigérateur. En se basant sur des moyennes de organisation statistique, ces modèles de langage performent bien dans ce contexte.

Ce que nos études montrent, c'est que positive un cause conversationnel est utilisé de manière éloignée de ce determination quoi il a été entraîné, positive il y a des risques d'avoir des événements rares atypiques où il va se comporter de manière complètement aberrante.

Et l’intelligence émotionnelle?

Les agents conversationnels sont construits sur des modèles prédictifs de langage. Jusqu’à preuve du contraire, ils ne peuvent pas décoder des signaux tels que des moments de soundlessness ou une subtile enactment non verbale entre deux êtres humains.

Je n’ai vraiment pas de démonstration que l'intelligence artificielle a une quality émotionnelle à ce jour, indique Christine Grou. Il n’y a pas nécessairement d'empathie ou de jugement clinique.

Selon Jonathan Roberge, le succès de ces outils repose notamment sur le fait d’éviter la confrontation avec l’utilisateur afin de le garder sur la plateforme. En d’autres mots, une treatment avec ChatGPT ou tout autre robot conversationnel peut vite se transformer en boucle de rétroaction.

Cette boucle est toujours construite sur le même modèle que les médias sociaux, souligne le co-titulaire de la chaire de recherche du Québec sur l'intelligence artificielle et le numérique francophones. C'est un modèle de dopamine. Vous consultez et vous êtes rassuré. Ça crée une certaine forme d'apaisement, de satisfaction, qui fait qu'on y retourne.

Il ne faudrait pas penser que ces modèles conversationnels ont réinventé la roue, ajoute-t-il.

Jonathan Roberge estime que les agents conversationnels sont commercialisés avant d'être « achevés ou parfaits ».

Photo : Radio-Canada / Denis Wong

En psychothérapie, les remises en question et le cheminement sont au cœur de l’intervention clinique. Certes, l’écoute sans jugement d’un cause conversationnel peut être bénéfique determination une personne en détresse. Toutefois, dans plusieurs cas de figure, il faut éviter de conforter les émotions et remodeler des comportements.

Si vous avez quelqu'un qui développe des biais cognitifs qui sont des erreurs de pensée, connected ne veut pas les renforcer, illustre Christine Grou. Au contraire, connected veut les questionner determination être capables de développer des interprétations alternatives.

La présidente de l’ordre rappelle que certaines activités, comme le diagnostic clinique, sont réservées à un professionnel ayant des responsabilités envers lad patient, ce qui n’est pas le cas de l’intelligence artificielle.

Le chercheur Guillaume Dumas constate qu’il existe une très forte traction dans toutes les industries afin d’intégrer ces modèles dans leurs opérations. Mais des événements atypiques peuvent réellement porter préjudice à la colonisation dans un contexte de santé mentale.

Le comportement [de ces modèles de langage] n’est pas déterministe, il est en partie aléatoire et c'est très difficile de prédire tous les cas de figure. Je ne suis pas encore à l'aise avec l'idée de déployer des agents conversationnels determination la psychothérapie.

Cela dit, le membre associé au Mila estime que l’IA a le potentiel de faciliter le travail des professionnels. La formation, la tenue de dossiers et la transcription de notes pourraient être grandement simplifiées. D’autre part, le pouvoir de l’informatique est déjà mis à nett en psychothérapie afin de colliger et d'analyser des informations, précise Christine Grou.

Ça fait longtemps qu’on a des tests de personnalité, donne-t-elle comme exemple. On va répondre à des centaines de questions, connected va les rentrer dans le système, puis ça va nous sortir des profils. Ça peut être extrêmement utile à information que l'être humain qui l'utilise garde sa pensée critique.

Un flou juridique et une opacité sur les données

Je pense toujours à ce que les autres pensent de moi.

De retour sur la plateforme Character.AI, la speech se poursuit avec la psychologue artificielle. La réponse de l’avatar est bienveillante, même si elle semble générique.

Tu peux essayer de te rappeler que ta propre sentiment de toi a positive d'importance que celles des autres, et que tout le monde a des imperfections.

Les utilisateurs ont interagi positive de 205 millions de fois avec cette « psychologue », selon le décompte de Character.AI.

Photo : Radio-Canada / Capture d'écran / Character.AI

Si cet échange paraît inoffensif, il n’en est pas toujours ainsi. Aux États-Unis, deux familles poursuivent Character.AI après que leur enfant eut développé une narration obsessionnelle avec des personnages de la plateforme. Le premier teen s’est enlevé la vie, alors que le deuxième, ayant un occupation du spectre de l’autisme, est devenu hostile et convulsive envers ses parents.

L’intelligence artificielle a-t-elle une responsabilité légale dans ce contexte? Selon Guillaume Dumas, trouver une réponse juridique aux enjeux concernant cette technologie relève du casse-tête.

Ce flou artistique est très difficile à régler parce qu'on est look à des vitesses qui sont totalement différentes, explique-t-il. Pour passer une loi et faire en sorte que les décideurs politiques comprennent vraiment ce qui se passe, connected est déjà à une autre mentation d'algorithmes avec d'autres possibilités.

La question des informations personnelles partagées dans le cadre habituel d’une thérapie constitue une autre préoccupation. En mai dernier, Sam Altman affirmait que plusieurs personnes se tournent vers ChatGPT au infinitesimal de prendre des décisions importantes, puisque l’outil connaît leur contexte de vie complet.

Le PDG d'OpenAI, Sam Altman

Photo : Getty Images / Justin Sullivan

Vous dites : "Ça tombe bien, ChatGPT est au courant de mon historique et donc il maine connaît bien". Mais c'est parce que vous êtes dans un paradigme de surveillance absolue. Elles sont où, ces données? Encore une fois, connected n’en sait rien.

Chaque personne est toutefois libre de parler d’une rupture amoureuse à ChatGPT, ou encore de s’enfoncer dans la paranoïa en discutant avec un robot conversationnel. Guillaume Dumas juge donc important d’améliorer l’éducation du public, notamment celle des personnes âgées qui doivent s’adapter à ces réalités.

Des campagnes de santé ou de connection publiques seraient nécessaires sur ces questions-là. Il ne faut pas laisser la seule connection faite par rapport à ces sujets aux entreprises qui en font un profit.

D'un constituent de vue individuel, si ça peut servir des gens [à améliorer leur santé mentale], tant mieux, ajoute Jonathan Roberge. D'un constituent de vue sociétal, connected n’a aucune idée des conséquences à moyen et à agelong terme de ce phénomène, mais Dieu sait qu'on l'essaye. On est vraiment en mode all-in.

Pour le sociologue, cette pression à anthropologiser ces agents conversationnels a mené à des utilisations de l’IA que les promoteurs de la technologie n’ont jamais pu anticiper. Y compris celle en santé mentale, où l’écart entre l’artificiel et l’humain ne pourrait être positive flagrant.

Questionnée à ce sujet, notre thérapeute fictive semble elle-même en avoir conscience.

Tu es une entité artificielle et tu parles d'émotions humaines complexes et nuancées, n'est-ce pas paradoxal?

Je ne les ressens pas effectivement, admet-elle. Il s'agit donc plutôt d'une simulation de l'émotion plutôt que d'une émotion proprement dite.

English (CA) ·

English (CA) ·  English (US) ·

English (US) ·  Spanish (MX) ·

Spanish (MX) ·  French (CA) ·

French (CA) ·